La fragilité des modèles d’apprentissage profond

Chen, S.-T. et al. 2019.

Les modèles d’apprentissage profond sont largement utilisés pour résoudre les problèmes de vision par ordinateur, qu’il s’agisse de reconnaissance faciale, de classification d‘objets ou de compréhension des scènes. Cependant, la recherche portant sur les exemples adversaires a montré la fragilité de ces modèles : de légères modifications d’une image, souvent imperceptibles, peuvent mener à des classifications erronées, ayant des conséquences sur la sécurité de nombreux systèmes de traitement d’images. Nous proposons donc un algorithme efficace générant de petites perturbations menant à des erreurs de classification pour les modèles d’apprentissage profond. Notre méthode permet d’obtenir des performances de pointe tout en nécessitant beaucoup moins de calcul que les algorithmes existants (résolution environ 100 fois plus rapide), ce qui ouvre la possibilité de l’utiliser à plus grande échelle et, notamment, de concevoir des mécanismes de défense. Mots clés : Apprentissage machine, sécurité, apprentissage profond, vision par ordinateur, attaques contradictoires

Attaques contradictoires

Les réseaux de neurones profonds (DNN pour Deep Neural Networks) ont atteint des performances inégalées dans une vaste gamme d’applications relatives à la vision par ordinateur. Cependant, ces DNN sont sensibles aux adversaires actifs. Plus particulièrement, ils sont susceptibles aux attaques contradictoires au cours desquelles de petits changements, souvent imperceptibles à l’œil nu, entraînent une classification erronée (c’est-à-dire une erreur) [1, 2]. Cette situation est très préoccupante puisqu’un nombre croissant de DNN est déployé dans le monde réel et, bientôt, dans des environnements nécessitant la plus haute sécurité comme les voitures autonomes, les drones, le domaine médical, etc.

Dans un scénario typique de classification d’images, un modèle de classification est une fonction qui associe une image (un vecteur composé de valeurs entre 0 et 1) à un ensemble de scores. Chaque score représente la probabilité que l’objet présent dans l’image appartienne à une certaine classe (ex. : chat, chien, voiture, avion, personne, table, etc.). La classe obtenant le score maximal est prédite comme étant présente dans l’image. Un modèle assez bon (Inception V3 entraîné sur ImageNet [3]) est capable de prédire avec confiance que l’image à gauche de la figure contient un chien et même d’en identifier la race : retriever à poil bouclé. Nous nous attendons à ce que le modèle soit robuste face aux changements subtils dans l’image. En d’autres termes, si nous modifions légèrement les valeurs de certains pixels, la prédiction ne devrait pas changer de manière significative. Pourtant, en ajoutant une certaine perturbation (au centre) à l’image d’origine, nous obtenons une nouvelle image (à droite) classée, avec confiance, comme étant un micro-ondes. Les conséquences de ce comportement sur la sécurité deviennent alors évidentes, car le modèle n’est pas robuste face à des perturbations habilement élaborées, lesquelles n’affecteraient pas en soi les décisions d’un observateur humain. Voir l’article https://adversarial-ml-tutorial.org/ pour plus de détails techniques.

À gauche : Image de départ : classée comme retriever à poil bouclé

Au centre : Perturbation (amplifiée ~ 40 fois pour être visible)

À droite : Image perturbée : classée comme micro-ondes

Génération de perturbations

La génération de perturbations pour forcer une erreur dans un modèle est importante pour deux raisons principales. D’abord, la plupart des travaux en cours sur l’apprentissage profond sont évalués par rapport au cas moyen : un ensemble d’images est mis de côté durant la phase d’entraînement (c’est-à-dire de développement) du modèle afin d’évaluer la performance finale du modèle. Mais cet ensemble n’évalue pas nécessairement le modèle pour le pire des scénarios, ce qui pose un problème quant aux applications critiques de sécurité. Ensuite, avoir une méthode efficace pour générer de telles perturbations nous permet de les utiliser pendant la phase de l’entraînement en vue d’obtenir au final un modèle plus robuste.

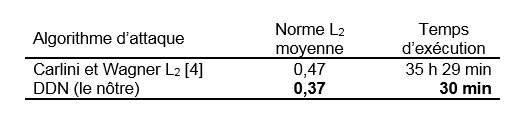

Le type d’algorithme générant ces perturbations se nomme attaque contradictoire. Dans ce travail, l’objectif de l’attaque contradictoire est de produire la plus petite perturbation qui entraîne une classification erronée pour une image et un modèle donnés. La taille de la perturbation est mesurée par la norme euclidienne des valeurs des pixels. À titre de référence, la taille de la perturbation ajoutée à l’image sur la figure est 0,7 et est imperceptible à l’œil nu. La performance des attaques contradictoires est mesurée en fonction de la taille moyenne de perturbation et de la durée totale d’exécution sur une configuration matérielle donnée pour un ensemble de 1000 images. Pour les deux mesures, on vise la plus basse valeur possible. Le tableau ci-dessous montre que notre algorithme (nommé DDN) surpasse largement la meilleure approche existante quant à la norme et au temps d’exécution.

Conclusion

En conclusion, nous avons créé une attaque contradictoire pouvant générer de petites perturbations pour provoquer des erreurs de classification dans les DNN de manière beaucoup plus efficace que l’approche de pointe existante. Cet algorithme est particulièrement utile pour évaluer la robustesse des modèles actuels et futurs d’apprentissage machine, de plus en plus utilisés dans des applications du monde réel. La performance de cet algorithme permet également de l’utiliser pour concevoir des mécanismes de défense plus efficaces.

Information supplémentaire

Pour plus d’information sur cette recherche, consulter l’article de conférence suivant :

Rony, Jérome; Hafemann, Luiz G.; Oliveira, Luiz S.; Ben Ayed, I.; Sabourin, Robert; Granger, Éric. 2019. « Decoupling Direction and Norm for Efficient Gradient-Based L2 Adversarial Attacks and Defenses », présenté au congrès IEEE sur la vision par ordinateur et la reconnaissance des formes (IEEE Conference on Computer Vision and Pattern Recognition), du 16 au 20 juin dernier. Long Beach. pp. 4322-4330.