Les chaînes de blocs pour l’apprentissage machine décentralisé

Achetée sur Istockphoto. Droits d’auteur.

L’apprentissage fédéré (AF) fonctionne de manière itérative en sélectionnant un sous-ensemble de clients à chaque tour, leur demandant de d’entraîner un modèle avec leurs données locales. Les clients partagent ensuite leur modèle avec le serveur qui agrège tous les modèles clients en un seul modèle global. Les approches d’AF traditionnelles sélectionnent généralement des ensembles aléatoires de clients à chaque tour, ce qui peut avoir un effet négatif sur la qualité du modèle entraîné. En outre, les clients sont souvent réticents à participer à l’apprentissage collaboratif en raison de l’absence de mécanisme sécurisé de monétisation. Cet article présente FL-MAB (Federated Learning-Multi-Auction using Blockchain), un mécanisme de sélection des clients pour AF par contrat intelligent, qui récompense les clients utilisant les cryptomonnaies.

Introduction

Habituellement, les données générées par l’Internet des objets (IdO) ne proviennent pas d’une entité unique, mais plutôt d’un grand nombre de parties. Or, vu les nouvelles lois sur la confidentialité des données et les surcharges (overhead) de transmission, il n’est pas réaliste de rassembler toutes les données des dispositifs IdO vers un nuage central lors d’un entraînement centralisé de modèle d’apprentissage machine.

L’apprentissage fédéré (AF) est issu de l’apprentissage machine et surmonte le problème de confidentialité en éliminant le stockage centralisé et en permettant l’entraînement collaboratif d’un modèle partagé avec données distribuées. Dans le contexte traditionnel d’AF, la sélection des clients pour l’entraînement est aléatoire à chaque tour d’AF. Ces clients sélectionnés au hasard peuvent avoir des ressources hétérogènes, soit une charge de batterie et une connectivité Internet variables. Par conséquent, tout client d’un réseau peut se déconnecter pendant l’entraînement et affecter l’exactitude globale du modèle. De plus, il existe des clients malveillants qui veulent intentionnellement mettre en péril l’écosystème AF en intimidant le modèle global par des attaques.

Le serveur peut être biaisé par la pratique de népotisme, c’est-à-dire qu’on favorise ses pairs en les sélectionnant et en les récompensant. De plus, les clients riches en ressources hésitent à participer à l’entraînement collaboratif en raison d’un mécanisme de monétisation peu sûr. Il est donc essentiel de concevoir un cadre AF sécurisé, qui protège la confidentialité et qui motive les clients riches en ressources à participer, en leur octroyant des récompenses selon leur contribution.

Intégration de chaîne de blocs à l’AF

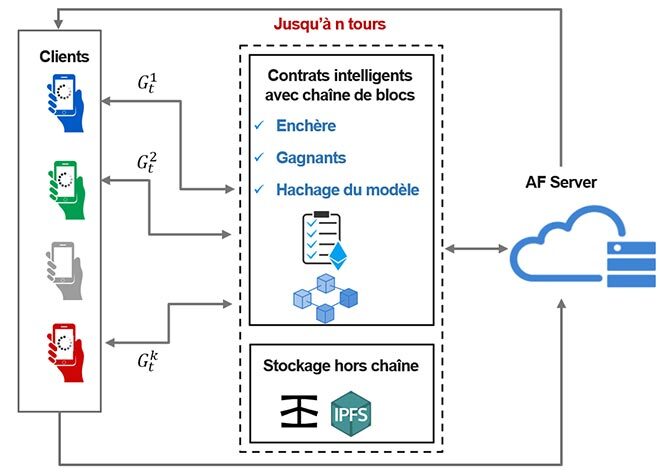

Une chaîne de blocs est une base de données distribuée inviolable qui assure l’auditabilité et l’imputabilité. Un réseau d’AF soutenu par une chaîne de blocs favorise la fédération d’un plus grand nombre de dispositifs en offrant un AF sécurisé. La chaîne de blocs permet l’interaction entre les entités du réseau, clients et serveur, et les oblige à être équitables en fournissant auditabilité, traçabilité, non-répudiation et monétisation sécurisée, comme le montre la figure 1.

Figure 1 : Intégration de chaîne de blocs à l’AF

Protocole proposé d’apprentissage fédéré

Le protocole proposé de sélection des clients FL-MAB comprend trois phases : enchère, apprentissage fédéré et récompense. D’abord, la sélection des clients se fera par enchère sous forme de contrats intelligents dans la chaîne de blocs. Ensuite, les clients soumettront leur offre avec des ressources, c’est-à-dire tous les échantillons de données locales, de bande passante et de connectivité Internet. Enfin, les clients ayant obtenu les meilleurs résultats seront désignés comme gagnants par la chaîne de blocs.

Dans la phase d’AF, les gagnants commenceront à entraîner leur modèle local à l’aide de leurs données privées. Le hachage du modèle local sera sauvegardé sur la chaîne pour éviter toute falsification. Enfin, le serveur effectuera une agrégation pour calculer le modèle global. La contribution de chaque client dans le modèle global sera calculée à la phase de récompense. Finalement, les clients seront récompensés en fonction de leur contribution en cryptomonnaies.

Validation de l’approche proposée

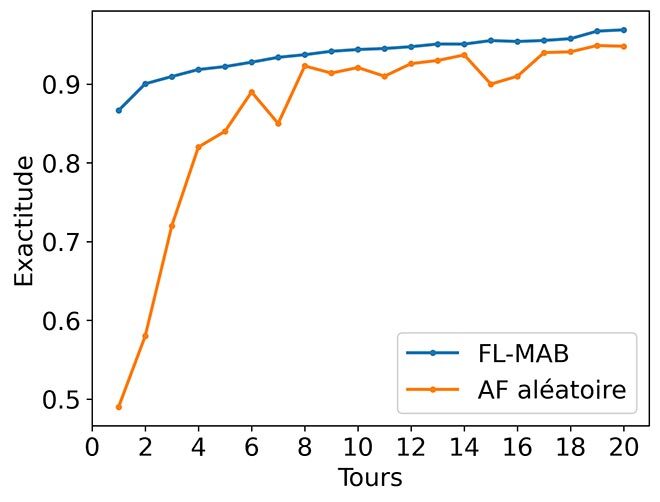

Nous avons comparé notre solution avec RandomFL, une approche traditionnelle d’AF où les clients sont choisis au hasard par le serveur pour participer aux tours d’AF. La figure 2 montre que FL-MAB augmente la vitesse de convergence et l’exactitude du modèle dans la tâche de reconnaissance de caractères manuscrits MNIST-O après le 20e tour d’entraînement, comparativement à RandomFL.

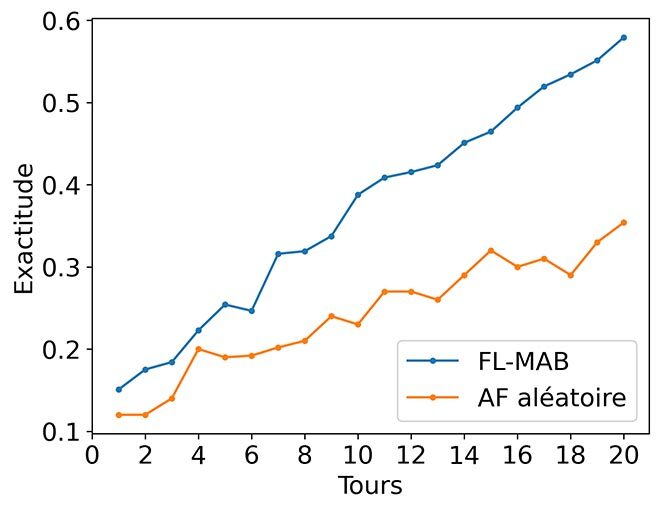

La figure 3 montre également une meilleure performance du modèle dans la tâche de classification d’images CIFAR-10. Comparée à RandomFL, l’exactitude de FL-MAB reste nettement plus élevée après le 20e tour d’entraînement en AF.

Fig. 2 : Comparaison d’exactitude – MNIST

Fig. 3 : Comparaison d’exactitude – CIFAR -10

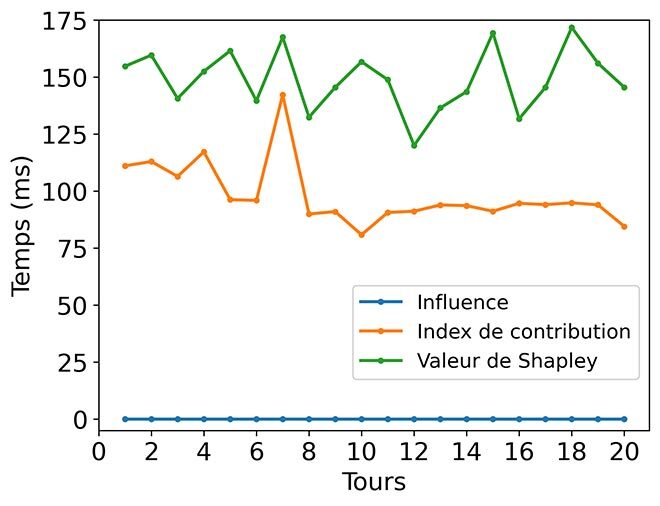

Nous avons appliqué trois méthodes différentes pour calculer la contribution marginale des clients, soit la valeur de Shapley, l’indice de contribution et la fonction d’influence. La figure 4 montre que notre méthode heuristique, l’indice de contribution Shapley, est environ 34 % plus rapide, car elle calcule la contribution marginale des clients en s’approchant des modèles de coalition.

Figure 4 : Comparaison des méthodes de distribution des récompenses

Conclusion

Nous proposons une solution qui favorise l’apprentissage fédéré tout en assurant à la fois la sélection des clients et une monétisation équitable à l’aide de contrats intelligents. Nos expériences démontrent que notre solution réduit le nombre de tours d’entraînement en éliminant les clients traînards et améliore l’exactitude du modèle. De plus, notre heuristique de récompense permet une monétisation équitable et est beaucoup plus rapide à exécuter que la méthode de référence.

Complément d’information

Pour plus d’informations sur cette recherche, veuillez lire l’article suivant : Batool, Z., Zhang, K., & Toews, M. (2022, April). FL-MAB: client selection and monetization for blockchain-based federated learning. In Proceedings of the 37th ACM/SIGAPP Symposium on Applied Computing (pp. 299-307).