Reconnaissance des émotions par fusion AV interattentionnelle

Achetée sur Istockphoto.com. Droits d’auteur.

L’analyse multimodale suscite un vif intérêt en informatique affective, car elle peut apporter une plus grande précision dans la reconnaissance des émotions (RE) par rapport aux approches unimodales. Ici, nous explorons la fusion intermodale de l’audio (A) et du vidéo (V) de manière complémentaire afin d’en extraire des représentations robustes de traits multimodaux. L’objectif est d’aborder le problème de la reconnaissance en continu des émotions dans lequel nous cherchons à estimer la large palette des émotions humaines sur une échelle continue de valence et de stimulation. Plus précisément, nous proposons une approche de fusion interattentionnelle pour extraire les principales caractéristiques des modalités AV afin d’obtenir une prédiction précise des valeurs de valence et de stimulation en continu. Notre nouveau modèle de fusion AV interattentionnelle exploite efficacement les liens AV intermodaux. En particulier, il calcule des poids interattentionnels pour mettre l’accent sur les caractéristiques les plus pertinentes des différentes modalités, combinant ainsi des représentations de traits contributifs, lesquels sont ensuite transmis aux couches de prédiction de valence et de stimulation. Notre travail présente beaucoup de possibilités dans les applications du monde réel (p. ex. estimation de l’intensité de la douleur ou de la dépression) et dans les soins de santé (p.ex. détection de la fatigue du conducteur dans les systèmes d’aide à la conduite).

La reconnaissance des émotions, un défi

La reconnaissance et l’analyse automatiques des émotions humaines ont suscité un vif intérêt ces dernières années. Leurs applications se retrouvent dans plusieurs domaines : soins de santé (évaluation de la colère, fatigue, dépression et douleur), robotique (interaction personne-machine), assistance au conducteur (évaluation de l’état du conducteur). La reconnaissance des émotions (RE) présente des défis importants, car les expressions liées aux émotions humaines sont de nature très diverse selon les personnes et les cultures.

Figure 1 : Émotions diverses selon les personnes et les cultures [1].

L’espace valence-stimulation

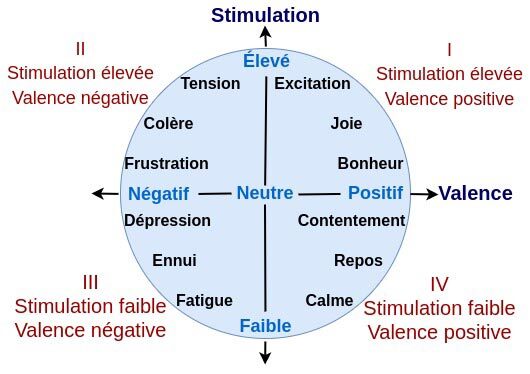

Récemment, les applications du monde réel ont fait passer la recherche en informatique affective d’environnements contrôlés en laboratoire vers des environnements naturels plus réalistes. Cette évolution force l’analyse d’un grand nombre d’états émotionnels subtils et continus, comme rencontrés dans le monde réel, p. ex. l’estimation de l’intensité de la douleur ou de la dépression. Normalement, les états émotionnels continus sont formulés comme un problème de RE dimensionnel, où les émotions humaines complexes sont représentées dans un espace dimensionnel. La figure 2 illustre l’espace bidimensionnel des états émotionnels, où la valence et la stimulation sont les axes dimensionnels. La valence reflète la large palette d’émotions dans la dimension du plaisir, de négative (frustration) à positive (bonheur), tandis que la stimulation couvre les intensités de passive (fatigue) à active (excitation).

Figure 2 : Espace valence-stimulation

Les systèmes multimodaux

La transmission des émotions humaines passe par diverses modalités, comme le visage, la voix, le texte et les biosignaux (électroencéphalogramme, électrocardiogramme, etc.), chacune d’entre elles véhiculant différentes informations. Bien que les émotions humaines s’expriment par différentes modalités, les modalités vocales et faciales sont les principaux canaux sans contact et disponibles sur vidéos donnant ainsi accès à des informations complémentaires. Ce travail nous a amenés à étudier la possibilité d’exploiter efficacement la nature complémentaire des relations AV captées sur vidéos pour améliorer les performances des systèmes multimodaux par rapport aux systèmes unimodaux. Par exemple, en l’absence de la modalité faciale due à la pose, au flou, à un éclairage faible ou autre, nous pouvons toujours recourir à la modalité audio pour évaluer l’état émotionnel et vice versa.

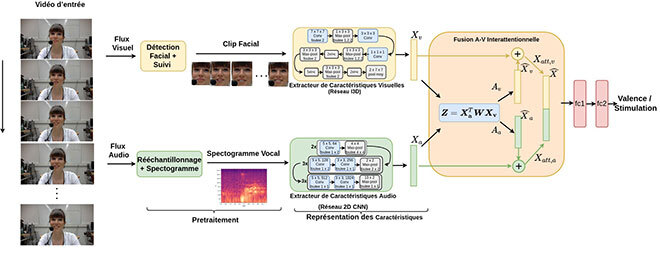

Figure 3 : Modèle de fusion AV dans la reconnaissance dimensionnelle des émotions

Dans un ensemble de séquences vidéo, nous avons extrait séparément les flux audio et vidéo : le flux vidéo a été prétraité pour obtenir des images recadrées et alignées, et le flux audio adapté pour obtenir les spectrogrammes des clips vidéo correspondants. Ensuite, nous avons transmis les flux aux dorsales vidéo et audio pour en extraire les caractéristiques correspondantes, que nous avons par la suite transmises au modèle interattentionnel. Dans le modèle de fusion (interattentionnel), nous avons obtenu les poids d’attention pour chaque modalité en fonction de la corrélation entre les caractéristiques audio et vidéo. Une corrélation plus élevée montre que les caractéristiques audio et vidéo sont fortement liées et qu’elles contiennent des informations pertinentes. Les caractéristiques finales sont ensuite obtenues à l’aide des poids d’attention et transmises à la couche de prédiction pour estimer la valence et la stimulation.

Complément d’information

Pour plus d’informations sur cette recherche, veuillez consulter les articles suivants :

[2] R. G. Praveen, E. Granger and P. Cardinal, « Cross Attentional Audio-Visual Fusion for Dimensional Emotion Recognition, » 2021 16th IEEE International Conference on Automatic Face and Gesture Recognition (FG 2021), 2021, pp. 1-8.